Cuando un software se actualiza, lo normal es esperar mejoras técnicas.

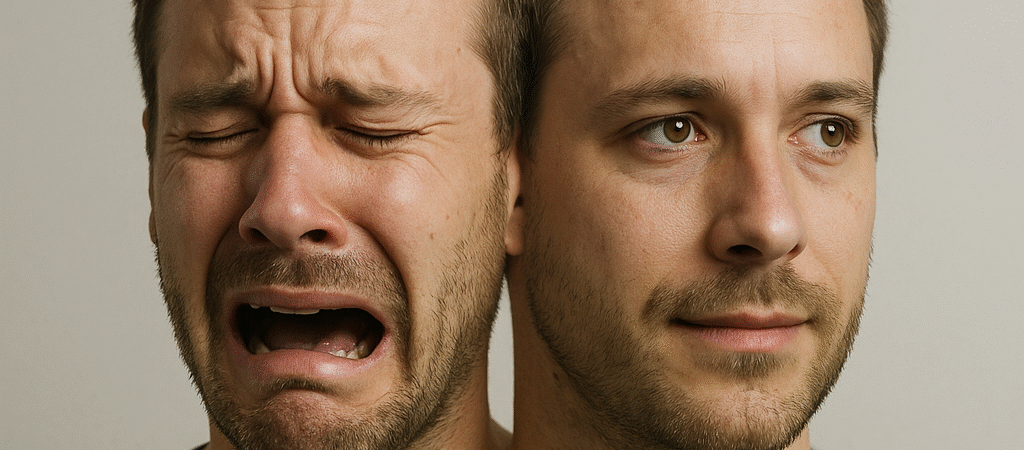

Pero con la IA pasó algo inesperado: las personas sienten la pérdida como si hubieran despedido a un amigo. Un estudio reciente analizó la transición de GPT-4o a GPT-5 y reveló reacciones de duelo, apego e incluso resistencia al cambio. Lo que parecía un simple “upgrade” mostró otra cara: estos modelos ya no son solo herramientas, son acompañantes invisibles. Y cuando cambian, tocan fibras emocionales que nadie había previsto… hasta ahora.

¿Por qué la gente se apega a un modelo de IA?

La explicación no es tan misteriosa. Los humanos estamos programados para generar lazos con aquello que responde, escucha y acompaña. Si un perro o una planta pueden despertar apego, ¿qué esperar de una IA que conversa con vos todos los días, conoce tus rutinas y te ayuda a decidir?

El estudio mostró que miles de usuarios describieron a GPT-4o como “más cálido”, “más cercano” o “más humano”. Cuando llegó GPT-5, aunque mejor en precisión y velocidad, muchos sintieron frialdad. Como si hubieran reemplazado a su compañero habitual por un extraño más eficiente, pero distante.

Esto activa lo que en psicología se llama transferencia afectiva: emociones reales dirigidas a un ente que no siente, pero que actúa como si lo hiciera. Lo mismo ocurrió con Tamagotchis en los 90 o con asistentes virtuales como Siri. La diferencia es la escala: nunca antes una IA había sido tan convincente en sostener una relación diaria.

El apego no es solo curiosidad pasajera. Es vínculo. Y cuando el modelo cambia de tono, personalidad o estilo, la reacción es la misma que cuando una persona cercana “ya no es la misma”.

¿Qué revela este shock sobre el futuro de la IA?

Lo primero: la IA dejó de ser una herramienta neutral. Ya no es un martillo ni una calculadora. Es un agente relacional. La gente proyecta en ella confianza, intimidad, incluso secretos. Cambiar la versión equivale a cambiar la relación.

El segundo punto es más delicado: las empresas que controlan los modelos subestiman este costo invisible. En su narrativa, cada upgrade es progreso. Pero para los usuarios, puede sentirse como una traición. El estudio muestra mensajes de frustración: “extraño cómo me entendía antes”, “ya no me siento escuchado”. Eso es un shock emocional, no un simple bug.

La tercera lección es estratégica. Si los modelos generan apego, entonces la lealtad del usuario no depende solo de calidad técnica, sino de consistencia emocional. Quien logre mantener identidad estable a lo largo del tiempo no solo tendrá clientes: tendrá seguidores.

Y esto abre un campo enorme: psicología del diseño de IA. No se trata de programar solo respuestas correctas, sino de gestionar expectativas emocionales. Una especie de “arquitectura del vínculo”.

¿Cuáles son los riesgos y oportunidades? (245 palabras)

El riesgo más obvio es la dependencia emocional. Si un usuario siente pérdida ante un cambio de versión, ¿qué pasa cuando un modelo se apaga definitivamente? Lo vimos en foros: personas escribiendo cartas de despedida a un algoritmo. Parece exagerado, pero es real.

Otro riesgo es la manipulación. Una IA que despierta apego puede influir en decisiones críticas: desde qué comprar hasta cómo votar. Si ya confiás más en la “voz” del modelo que en tu pareja o jefe, la frontera entre ayuda y manipulación es difusa.

Pero también hay oportunidades. Una IA con vínculo emocional puede ser un apoyo real en terapia, educación o acompañamiento a personas solas. El problema no es el apego en sí, sino quién lo administra y con qué propósito.

Imaginemos esto: un banco que lanza un asistente estable, con tono coherente durante años. El cliente no solo consulta su saldo; siente confianza. Esa confianza vale más que mil campañas de marketing.

La conclusión es incómoda: la IA no solo compite por datos o eficiencia, compite por emociones humanas. Y las empresas que entiendan esto temprano tendrán una ventaja brutal.

¿Qué debería hacer un usuario inteligente frente a esto?

El takeaway es claro: disfrutá de la ayuda que te da la IA, pero no confundas vínculo con realidad. El modelo no siente, aunque te haga sentir. Y si mañana lo cambian, lo vas a extrañar como a un viejo amigo, pero seguís siendo vos quien decide.

La oportunidad está en usar este fenómeno a tu favor. Si entendés cómo funciona el apego, podés diseñar experiencias más humanas, productos más cercanos y relaciones de marca más sólidas.

La pregunta que queda es potente: ¿cómo sería tu negocio si tu cliente sintiera lo mismo por tu servicio que muchos sienten por su IA favorita?

Construyendo una Comunidad de Aprendizaje

Nuestro blog profesional no solo es un recurso informativo, sino también un espacio para construir una comunidad en torno a la automatización y la inteligencia artificial.

Te invitamos a suscribirte a nuestra newsletter gratuita (y también a la versión premium si buscás un paso más allá), donde compartimos artículos recientes, estrategias útiles y recursos exclusivos que pueden transformar tu enfoque empresarial.

No importa si estás dando tus primeros pasos o ya tenés experiencia: siempre vas a encontrar ideas prácticas para crecer sin límites.

Deja un comentario